Warum der KI-Textgenerator ChatGPT so fasziniert

Der Chatbot ChatGPT generiert zu jedem Thema erstaunliche Texte und hat Antworten auf jede Frage. Wir blicken auf die Möglichkeiten und Grenzen der Technologie.

Als die Firma OpenAI Ende 2022 ChatGPT vorstellte, begann der riesige Hype. Innerhalb von fünf Tagen meldete Chef Sam Altman mehr als eine Million registrierte Nutzer. Der Chatbot wurde zunächst zum Opfer seines eigenen Erfolgs: Es konnte passieren, dass ChatGPT seinen Nutzern nur sehr langsam antwortete oder wegen zu großen Andrangs sogar seine Pforten schloss.

Dabei sind KI-Sprachmodelle nicht neu. GPT-3 etwa, auf dem auch ChatGPT aufbaut, existiert schon seit 2020 – wir haben ausführlich darüber berichtet [1]. Doch erst mit dem Start von ChatGPT wurde einer breiten Öffentlichkeit klar, welches Potenzial diese Technik entfalten kann.

- ChatGPT ist der einfache und kostenlose Zugang zum Sprachmodell von OpenAI, das Fragen per Chat beantwortet und beliebige Texte generiert.

- Seine Möglichkeiten sind überaus mächtig. Sie werden grundlegende Prozesse in vielen Branchen verändern.

- Dennoch hat ChatGPT klare Einschränkungen: So gibt es keine Garantie, dass seine Angaben alle korrekt und vollständig sind.

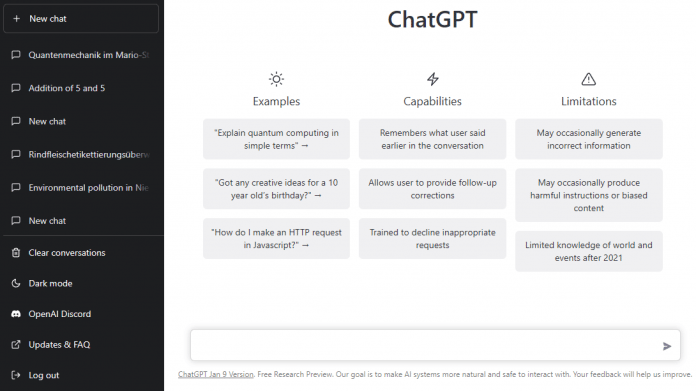

Waren Sprachmodelle bisher eher kompliziert zu bedienen (oder nur über eine Programmierschnittstelle), kommt ChatGPT mit einer bestechend einfachen Oberfläche daher: Man chattet einfach per Tastatur und Browser mit dem System. Der Exkurs auf der letzten Seite beschreibt im Detail die Optimierungen, die OpenAI vorgenommen hat, um die Fähigkeiten des zugrundeliegenden GPT-3 einer breiten Öffentlichkeit zugänglich zu machen.

Dieser Artikel stellt ChatGPT und seine Auswirkungen vor. Im zweiten Beitrag der Reihe [2] zeigen wir, wie Sie das Sprachmodell mit den richtigen Hilfsmitteln und Befehlen ausreizen und reißen einige Nutzungsszenarien an. In einem weiteren Artikel [3] haben wir eine Auswahl von KI-Diensten zusammengestellt, die ChatGPT und andere Sprachmodelle für konkrete Anwendungen verwenden. Und der Artikel beleuchtet die neuen Probleme mit dem Urheberrecht und anderen Gesetzen, die KI-generierte Texte und Bilder aufwerfen.

Alarm im Lehrerzimmer

Mit dem Auftauchen von ChatGPT wurde schnell klar, dass Schüler in Zukunft so manche Hausaufgabe an die KI delegieren können: Eine Zusammenfassung des Schimmelreiters etwa spuckt der Bot in Sekundenschnelle aus. Bei der Lösung eines linearen Gleichungssystems erklärt der Chatbot sogar ausführlich den Lösungsweg. Es gibt kaum ein Schulfach, in dem er nicht helfen kann. ChatGPT selbst schreibt auf Anfrage: "Ich kann Ihnen helfen, Fragen zu einer Vielzahl von Themen zu beantworten, darunter Mathematik, Physik, Chemie, Biologie, Geschichte, Literatur, Geografie, Politik und vielem mehr."

Die Schulbehörde des Bezirks New York hat den Einsatz des Chatbots prompt verboten. Die Begründung: Er helfe nicht dabei, kritisches Denken und Problemlösungskompetenzen einzuüben. Heinz-Peter Meidinger, Präsident des Deutschen Lehrerverbandes, reagierte gegenüber dem ZDF gelassener: Schüler hätten schon lange die Möglichkeit, sich im Internet Hilfe zu holen. Lehrkräfte würden schnell merken, ob jemand Aufgaben selbstständig gelöst habe, sagte er dem Sender. Und Robert Lepenies, Präsident der Karlshochschule International University in Karlsruhe, will die Künstliche Intelligenz sogar in den Seminarbetrieb seiner Hochschule einbinden [19]. Die akademische Welt diskutiert [20] derzeit bereits, in welcher Form der Beitrag von ChatGPT zu akademischen Arbeiten [21] gewürdigt werden soll.

Aber ChatGPT erleichtert nicht nur das Schreiben von Hausaufgaben und akademischen Arbeiten. Der Chatbot generiert auf Zuruf in etlichen Sprachen Texte der verschiedensten Genres: von Überschriften, Social-Media-Posts und Gedichten bis hin zu längeren Texten wie Newsletter, Reden, Pressemitteilungen oder Bewerbungsschreiben – und das in verschiedenen Sprachen. Er kann Texte sprachlich veredeln, gliedern und zusammenfassen. Wer mag, kann im Zusammenspiel mit ChatGPT ganze Romane entwerfen, mit einer groben Struktur und Subplots. Last, but not least spuckt ChatGPT Beispielcode für viele Aufgaben der Softwareentwicklung aus und analysiert vorgegebene Programme auf Fehler.

Hype und Umgang mit Informationen

Text-KI überall

Mit ChatGPT haben Sprachmodelle ihren iPhone-Moment. Zur Erinnerung: Als Steve Jobs im Jahr 2007 das Smartphone erstmals präsentierte, gab es bereits Handys mit Internetanschluss oder Touchscreen. Aber erst das iPhone bereitete den Weg für den Siegeszug der Smartphones. Entsprechend kann jetzt jeder selbst sehen und ausprobieren, welche praktischen Verwendungsmöglichkeiten Sprachmodelle ermöglichen. Der aktuelle Hype um ChatGPT ist nur der Anfang, die Technik wird schnell in weitere Dienste und Anwendungen einfließen. Schon heute ist es möglich, die Dienste von ChatGPT über Browser-Erweiterungen [23] in beliebige Web-Formulare einzubinden oder die Suchergebnisse von Google mit Resultaten von ChatGPT anzureichern. Und einige Suchmaschinen bauen bereits selbst maßgeschneiderte Antworten per Sprachmodell [24] zusammen.

In Zukunft wird eine KI-Hilfe überall dort selbstverständlich sein, wo man Texte verfasst. Unterstreicht die Autokorrektur bei Otto Normalanwender heute Tippfehler, lässt er sich morgen bei Schreibblockaden eine Dokumentstruktur und Textvorschläge unterbreiten oder gleich die komplette E-Mail in Inhalt und Ton auf den Empfänger abgestimmt schreiben.

Microsoft setzt jedenfalls auf OpenAI und ChatGPT. Der Softwareriese will sich mit zehn Milliarden US-Dollar an OpenAI beteiligen und hat angekündigt, ChatGPT in seine Suchmaschine Bing zu integrieren. Dritte werden in der Lage sein, den Chatbot über die Cloud-Dienste von Microsoft in ihre Anwendungen einzubauen. Bei OpenAI läuft ChatGPT derzeit im Betabetrieb und ist für Nutzer kostenlos. Das Unternehmen bereitet offenbar ein Freemium-Modell für seinen Chatbot vor: Gegen eine monatliche Gebühr will OpenAI auch bei hoher Auslastung Zugriff, schnellere Antworten und schnelleren Zugang zu neuen Funktionen bieten.

Nach dem Erfolg von ChatGPT ist davon auszugehen, dass alle großen Tech-Unternehmen schnell reagieren werden. Google jedenfalls "flippt" derzeit wegen ChatGPT "aus", wie das Online-Magazin The Verge berichtet. Demnach will Google "in diesem Jahr" 20 neue KI-Produkte auf den Markt bringen, darunter eine Demo einer Suchmaschine mit Chatbot-Fähigkeiten.

Gefährliches Halbwissen

Bei aller Begeisterung über die Fähigkeiten von ChatGPT und anderen Sprachmodellen darf man die Einschränkungen dieser Systeme nicht aus den Augen verlieren. So bringen ChatGPT & Co. zwar schöne, gut gebaute Sätze zustande. Auch wenn das Etikett "künstliche Intelligenz" an den Sprachmodellen klebt, haben sie kein wirkliches Weltwissen. Da die Texte nur auf Wortwahrscheinlichkeiten beruhen, können sich falsche Angaben einschleichen. Im folgenden Artikel zeigen wir einige Beispiele, etwa wie wir ChatGPT dazu "überreden", 5 + 5 = 11 als richtig anzusehen.

Derzeit lässt sich kaum prüfen, ob ein Text aus der Feder eines Menschen oder einer KI stammt. Informationen hinterfragt man vielleicht eher, wenn sie unkontrolliert aus einem Automaten stammen, als wenn ein Mensch sie geschrieben hat, dessen Expertise für das Thema vielleicht sogar kennt. Umso wichtiger ist es, Texte zu kennzeichnen, die komplett von einer KI geschrieben wurden. Im Januar war bekannt geworden, dass das Online-Portal CNET Dutzende von KI-Artikeln ungeprüft veröffentlicht hatte, ohne sie als solche zu kennzeichnen. KI-generierte Inhalte können auch zu urheber- und anderen rechtlichen Problemen führen. Der Artikel behandelt diese und andere rechtliche Fragen von Texten, Bildern und anderen per KI künstlich generierten Inhalten.

Fazit

Rechnen, lesen, schreiben, eine KI einen Text schreiben lassen: Falls Sie ChatGPT noch nicht ausprobiert haben, sollten Sie das nachholen. Der Umgang mit KI-Textwerkzeugen wird über kurz oder lang zu den digitalen Grundfertigkeiten gehören. Fiktionale und künstlerische Texte, bei denen der Wahrheitsgehalt und die Faktenlage keine große Rolle spielen, gelingen der KI erstaunlich gut. Es macht Spaß, den Bot ein Gedicht über das Rindfleischetikettierungsüberwachungsaufgabenübertragungsgesetz oder eine Geschichte über die Begriffe schreiben zu lassen, die gerade bei Twitter trenden.

Hintergrund: Funktionsweise und Training

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden.

Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden.

Mehr dazu in unserer

Datenschutzerklärung [25].

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung [25].

Transformer-Netzwerk

ChatGPT baut auf dem Sprachmodell GPT-3 auf, das OpenAI bereits 2020 entwickelt hat. GPT-3 produziert Texte in nahezu fehlerfreiem Englisch und in jedem beliebigen Stil. Das neuronale Netz hat das mithilfe von terabyteweise Text aus dem Internet im sogenannten Pretraining gelernt – daher das P im Namen. Dabei hat es gelernt, möglichst ähnlich wie in den Trainingsdaten weiterzuschreiben (Generative, das G aus dem Namen).

GPT-3 ist ein Transformer-Netzwerk (das T aus dem Namen), eine kurz vorher entwickelte Netzwerkstruktur mit einer entscheidenden neuen Idee: Transformer nutzen auf jeder ihrer Schichten einen Aufmerksamkeitsmechanismus. Diesen Mechanismus kann man sich als ein minimalistisches neuronales Netz vorstellen, das lernt, was gerade nicht zum Thema gehört. Durch diesen Mechanismus lernen Transformer, sich auf bestimmte Daten zu konzentrieren. In einem gesonderten Artikel haben wir Transformer im Detail erklärt [26]. Der Mechanismus ermöglicht zudem, neuronale Netze in nie da gewesener Größe zu trainieren. GPT-3 hat 175 Milliarden Parameter [27] – viel Platz für Sprach- und Weltwissen.

GPT-3 kann Texte erzeugen, die wirken, als habe es einfach nur Vorhandenes aus dem Internet abgeschrieben oder zusammenkopiert. Versucht man, dem Sprachmodell wie einem menschlichen Gegenüber Fragen zu stellen, liefert es oft inhaltsleere oder falsche Antworten und manchmal auch Gegenfragen. An den Sprachfertigkeiten von GPT-3 zweifelt niemand, aber sie sind also nicht gut genug auf den Menschen "ausgerichtet", um bestimmte Fragen zufriedenstellend zu beantworten. OpenAI nennt das Problem "alignment" [28].

Beim Training neuronaler Netze können zwei Probleme auftreten. Entweder springt der Lernalgorithmus hin und her, weil die Trainingsdaten stets große Veränderungen an den Parametern bewirken. Das passiert, wenn viel Rauschen im Datensatz steckt und das Netz keine Struktur darin erkennen kann. Oder die Daten geben keine eindeutige Richtung vor (zu kleine Gradienten), sodass der Algorithmus kaum noch etwas an den Parametern ändert. OpenAI hatte bei GPT-3 das zweite Problem. Wie also könnte man Gradienten berechnen, die genau dann groß sind, wenn das Sprachmodell gekonnt an der Frage vorbeischreibt?

KI-Training

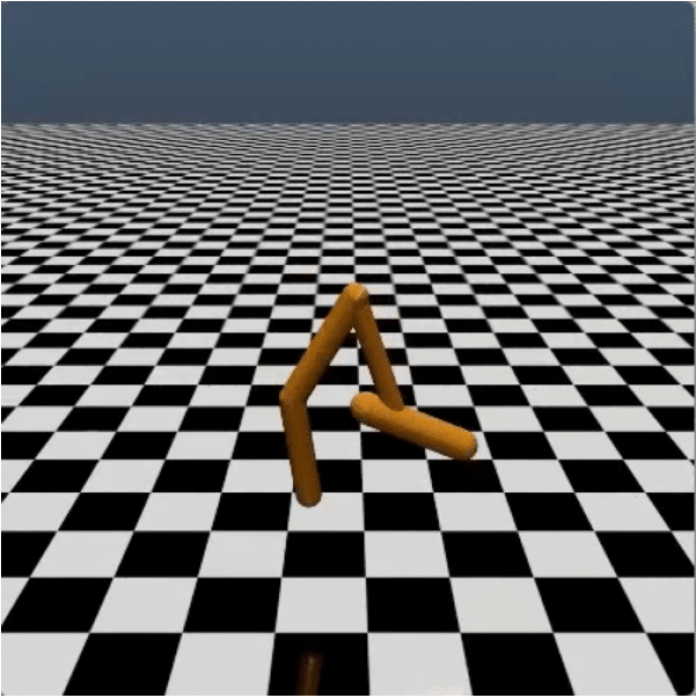

Für die Antwort bedienten sich die Forscher an einer Idee aus dem Reinforcement Learning. Dabei trainiert man einen Agenten, der in einer Spielumgebung Dinge tut und hin und wieder belohnt oder bestraft wird. Forscher in dieser Disziplin testen ihre KIs typischerweise mit pixeligen Arcade-Spielen aus den 80ern. Das Problem dabei: Punkte gibt es erst nach einer ganzen Reihe von Spielzügen und die KI muss beim Training selbst herausfinden, welcher Spielzug letztlich für den Punktgewinn wichtig war, um zu lernen, den dann häufiger zu machen. Die übliche Lösung besteht darin, ein kleines neuronales Netz zu trainieren, das vorhersagt, ob es demnächst Punkte gibt. Dessen Einschätzung nutzt dann der Lernalgorithmus für den Agenten und schon bekommt man ein Lernsignal für jeden Spielzug.

Für Pong und Breakout braucht man nicht viel mehr, weil die Spiele oft Punkte vergeben und die KI nicht so viele Möglichkeiten hat. Will man aber einem Strichmännchen in einer Physiksimulation einen Salto beibringen, gibt es viel zu viele Möglichkeiten, eine Vielzahl einzelner Gelenke zu bewegen. Die Wahrscheinlichkeit, den richtigen Bewegungsablauf zufällig zu finden, ist praktisch null. Schaut ein Mensch dem verdreht auf dem Boden liegenden Strichmännchen bei seinen Zuckungen zu, sieht er sofort, dass das so nichts wird.

(Bild: OpenAI, https://openai.com/blog/deep-reinforcement-learning-from-human-preferences/)

Strichmännchen in Bewegung

Genau diese Expertise hat sich OpenAI zunutze gemacht: Sie ließen Menschen je zwei Bewegungsversuche der Strichmännchen beurteilen und verwendeten diese Information als Trainingsdaten für ein neuronales Netz, das vorhersagt, was ein Mensch sagen würde. Mit dem Netz trainierte OpenAI den Reinforcement-Learning-Agenten, ließ den wieder etwas gekonnter zucken und die Menschen wieder entscheiden, und so weiter. Nach ein paar hundert Durchläufen dieser Art hatte das Strichmännchen einen passablen Salto gelernt. Diese Idee [29] verbunden mit einer etwas trickreicher gestalteten Loss-Funktion ("Objective Function" beim Reinforcement Learning) nennt OpenAI "Proximal Policy Optimization", kurz PPO [30].

Die Loss-Funktion legt fest, wann der Lernalgorithmus ein neuronales Netz belohnt oder bestraft. Für ein effektives Training muss die Funktion genügend Rückmeldung geben, um bei jedem Lernschritt einen spürbaren Fortschritt zu erzielen, aber nicht so extrem, dass das Netz sein gesamtes bisheriges Wissen über Bord wirft. In den letzten Jahren waren die meisten Fortschritte bei neuronalen Netzen auf bessere Loss-Funktionen und nicht auf eine andere Netzstruktur zurückzuführen.

Vom Strichmännchen zum Schreiberling

Die Idee, dass Menschen die Daten für eine trainierte Loss-Funktion erzeugen, funktioniert nicht nur mit Arcade-Spielen und Physiksimulationen, sondern auch mit Frage-Antwort-Spielen: OpenAI ließ also GPT-3 Fragen mehrfach unterschiedlich beantworten und bezahlte Leute dafür, die verschiedenen Antworten nach ihrer Nützlichkeit zu sortieren. Mit diesem im Vergleich zum Pretraining viel zu kleinen Datensatz trainierten sie ein kleines Netz und benutzten es mit PPO, um GPT-3 zu optimieren. Damit es dabei seine früheren Fähigkeiten nicht ganz vergaß, streuten sie immer wieder Trainingsläufe nach dem alten Schema ein. PPO lieferte wieder deutlich größere Gradienten, und das Sprachmodell wurde auch ohne zusätzliche Neuronen besser. OpenAI nennt das nachtrainierte GPT-3 für besseres Alignment InstructGPT, weil es besser den Instruktionen aus den Anweisungen folgt.

Im letzten Schritt entstand aus InstructGPT schließlich ChatGPT [31], indem OpenAI den Kontext der bisherigen Konversation in das Sprachmodell integrierte. Dazu gehören sowohl die Fragen als auch die eigenen Antworten. Während man bei GPT-3 auf 2048 Tokens (also rund 8000 Zeichen bei englischen Texten) begrenzt war, berücksichtigt ChatGPT beliebig viel Text aus dem Chat.(pmk@ct.de [32])[Link auf :] [33]

(jo [34])

URL dieses Artikels:

https://www.heise.de/-7480433

Links in diesem Artikel:

[1] https://www.heise.de/select/ct/2022/9/2204711293271197537

[2] https://www.heise.de/ratgeber/ChatGPT-mit-Prompts-Browser-Add-ons-und-Tools-ausreizen-7480141.html

[3] https://www.heise.de/ratgeber/KI-Dienste-im-Ueberblick-Welche-Tools-es-gibt-und-was-sie-koennen-7478380.html

[4] https://www.heise.de/ratgeber/Wie-man-Quizze-und-Kreuzwortraetsel-mit-ChatGPT-erstellt-9595840.html

[5] https://www.heise.de/hintergrund/Plug-ins-fuer-ChatGPT-Welche-es-gibt-und-was-sie-koennen-9218218.html

[6] https://www.heise.de/hintergrund/ChatGPT-Wie-KI-Regulierungen-der-EU-Grundrechtsverletzungen-verhindern-sollen-7543888.html

[7] https://www.heise.de/hintergrund/ChatGPT-Feintuning-Wie-man-die-KI-optimal-einsetzt-7532095.html

[8] https://www.heise.de/hintergrund/Praxiserfahrungen-Programmieren-mit-KI-Codeassistent-Github-Copilot-7538697.html

[9] https://www.heise.de/hintergrund/KI-im-Stress-Die-wundersame-Emotionalitaet-des-Bing-Chat-7538603.html

[10] https://www.heise.de/hintergrund/ChatGPT-als-Hacking-Tool-Wobei-die-KI-unterstuetzen-kann-7533514.html

[11] https://www.heise.de/hintergrund/Programmieren-ChatGPT-per-API-in-eigene-Programme-einbinden-7538616.html

[12] https://www.heise.de/ratgeber/Warum-der-KI-Textgenerator-ChatGPT-so-fasziniert-7480433.html

[13] https://www.heise.de/ratgeber/ChatGPT-mit-Prompts-Browser-Add-ons-und-Tools-ausreizen-7480141.html

[14] https://www.heise.de/ratgeber/ChatGPT-Urheberrecht-und-Datenschutz-bei-KI-generierten-Werken-7481725.html

[15] https://www.heise.de/ratgeber/KI-Dienste-im-Ueberblick-Welche-Tools-es-gibt-und-was-sie-koennen-7478380.html

[16] https://www.heise.de/ratgeber/Goodbye-Schreibblockade-KI-Textgeneratoren-ausprobiert-7263845.html

[17] https://www.heise.de/hintergrund/KI-Sachlich-korrekte-Texte-mit-neuronalen-Sprachmodellen-generieren-6668291.html

[18] https://www.heise.de/hintergrund/Neuling-in-der-Klasse-ChatGPT-und-Co-kommen-in-die-Schule-9237002.html

[19] https://www.heise.de/news/Interview-Wie-ChatGPT-die-Lehre-veraendert-7451975.html

[20] https://www.heise.de/news/Forschung-ChatGPT-bereits-als-Co-Autor-mehrerer-Fachartikel-genannt-7464363.html

[21] https://www.ghacks.net/2023/01/27/chatgpt-cant-be-credited-academic-author/

[22] https://www.heise.de/ct/

[23] https://www.heise.de/ratgeber/ChatGPT-mit-Prompts-Browser-Add-ons-und-Tools-ausreizen-7480141.html

[24] https://www.heise.de/select/ct/2023/4/2300610555933424240

[25] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[26] https://www.heise.de/hintergrund/KI-So-funktionieren-kuenstliche-Sprachsysteme-vom-Typ-Transformer-7077832.html

[27] https://www.heise.de/hintergrund/Skalierungshypothese-Welche-naechsten-Schritte-muss-die-KI-Forschung-gehen-7315964.html

[28] https://openai.com/blog/instruction-following/

[29] https://openai.com/blog/deep-reinforcement-learning-from-human-preferences/

[30] https://openai.com/blog/openai-baselines-ppo/

[31] https://openai.com/blog/chatgpt/qwe.sh/%2F../

[32] mailto:pmk@ct.de

[33] :

[34] mailto:jo@ct.de

Copyright © 2023 Heise Medien